רגע! לפני שהולכים... 👋

אל תפספסו! מסלולי לימוד נפתחים בקרוב - מקומות מוגבלים

| מסלול Cyber | 15/02 |

| מסלול Machine Learning | 15/02 |

| מסלול Computer Vision | 15/02 |

| מסלול RT Embedded Linux | 23/02 |

✓ ייעוץ אישי ללא התחייבות | תשובה תוך 24 שעות

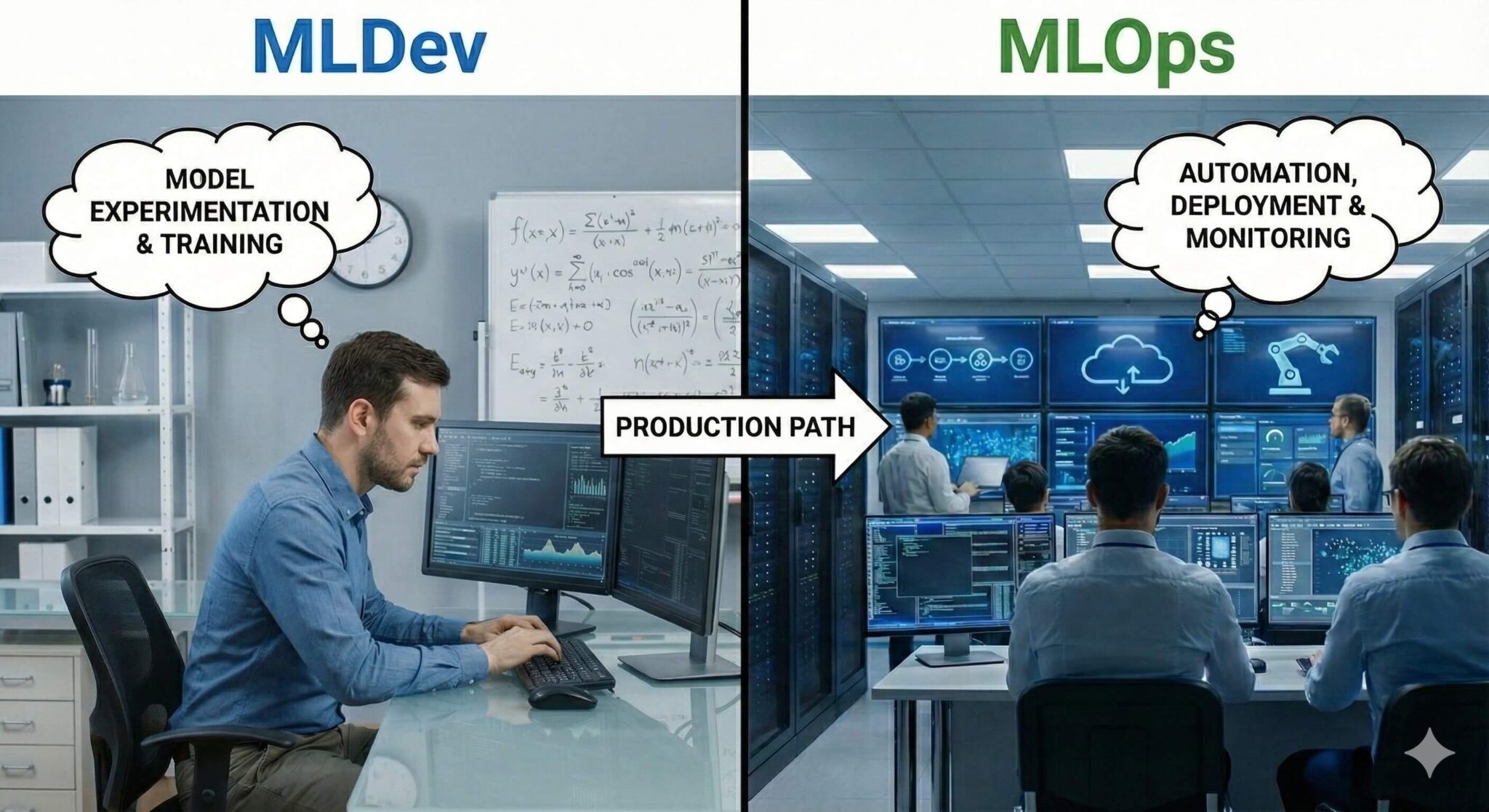

MLops vs MLdev

עודכן לאחרונה: 27 ינואר, 2026

- מה ההבדלים בין שני התפקידים

- הגדרות תפקיד: ML Developer ו‑MLOps

- מחזור החיים של מודל ML: מי עושה מה

- גבולות הגזרה והסינרגיה בין ML Dev ו‑MLOps

- כלים וטכנולוגיות: מה בארגז הכלים של כל אחד

- דוגמה מעשית: מסיפור משתמש למודל בפועל

- כיווני התפתחות קריירה ומודלים היברידיים

- סיכום על התפקידים המרכזיים בעולם Machine Learning

- שאלות נפוצות על MLops & ML dev

מה ההבדלים בין שני התפקידים

בשנים האחרונות, פיתוח מוצרי למידת מכונה הפך ממהלך ניסיוני למרכיב מרכזי באסטרטגיית העסקים של חברות טכנולוגיה, עם השקעות של מיליארדי דולרים בשנה. עם זאת, רוב המודלים שנבנים לעולם לא מגיעים לפרודקשן יציב – רק כ-10% מהמודלים "שורדים" מעבר לשלב הניסוי.

אתגרי המעבר ממודל ניסיוני למערכת עסקית

המעבר הזה דורש התמודדות עם אתגרים ייחודיים ל‑ML:

- סטטיסטיות: מודלים שמצליחים ב‑test set נכשלים בפרודקשן עקב Data Drift או Concept Drift.

- תשתיות מורכבות: מודל ML הוא לא רק קוד – הוא דורש נתונים רציפים, תשתית סקיילבילית( שניתנת להתפתח ולשרוד עומסים ופיקים של עיבוד), ניטור בזמן אמת, לזיהוי צוארי בקבוק ושגיאות עיבוד, ויכולת rollback מהיר.

- רגולציה ואמינות: בתחומים כמו פיננסים, בריאות ורגולציה (GDPR), דרושה שקיפות מלאה, audit trail ו‑explainability.

למה לא מספיק "Data Scientist אחד שעושה הכל"

Data Scientist מצוין יכול לבנות מודל מדהים, אבל הוא בדרך כלל:

- חלש בתשתיות DevOps ופריסה.

- לא מכיר את דרישות ה‑SRE (Site Reliability Engineering) של מערכות ייצור.

- מתמקד באלגוריתמיקה, לא בתפעול יומיומי או אופטימיזציה של latency/cost.

ML Developer ו‑MLOps

- ML Developer: המומחה לפיתוח המודל עצמו – אלגוריתמיקה, ניסויים, אופטימיזציה של ביצועים מדעיים.

- MLOps Engineer: המומחה להפעלה תפעולית – אוטומציה של pipelines, פריסה, ניטור, תשתיות ואמינות.

אני אפרק את ההבדלים, ואציג את נקודות הממשק ביניהם, ואסביר איך הסינרגיה הזו מאפשרת ל-90% מהמודלים להגיע לפרודקשן ולשרוד שם לאורך זמן.

הגדרות תפקיד: ML Developer ו‑MLOps

הגדרות תפקיד: ML Developer ו‑MLOps

בטרם נצלול למחזור החיים המשותף, חשוב להגדיר במדויק מהו כל תפקיד. ההגדרות הללו מבוססות על פרקטיקות מקובלות בתעשיית ה‑ML, כאשר ML Developer מתמקד בפן הטכני-מדעי ו‑MLOps בפן התפעולי-הנדסי.

מה זה ML Developer / ML Engineer / ML Dev

ה‑ML Developer אחראי על פיתוח המודל עצמו – מהבנת הבעיה העסקית, דרך ניתוח נתונים ועד לבניית מודל אופטימלי.

- אחריות עיקרית: תכנון ארכיטקטורת מודלים, ניסויים בהיפר-פרמטרים, אופטימיזציה של accuracy/precision/recall, ותיעוד מדעי.

- פוקוס מקצועי: אלגוריתמיקה מתקדמת, הבנת הדומיין, feature engineering, והתמודדות עם בעיות כמו overfitting או data leakage.

- מדדי הצלחה: שיפור ביצועי המודל (למשל, F1-score מ‑0.75 ל‑0.85), זמן פיתוח מודל קצר, ויכולת להסביר תוצאות לעמיתים.

מה זה MLOps Engineer

ה‑MLOps Engineer מתמקד בהפעלת המודל בקנה מידה תעשייתי – מאוטומציה של תהליכי אימון ועד ניטור בפרודקשן.

- אחריות עיקרית: בניית CI/CD pipelines ל‑ML, פריסת מודלים כ‑microservices, ניהול תשתיות (Kubernetes, cloud), וניטור drift ותקלות.

- פוקוס מקצועי: אמינות (uptime >99.9%), latency נמוך, cost optimization, ותמיכה בכמה גרסאות מודל במקביל.

- מדדי הצלחה: זמן פריסה קצר (minutes ולא days), שיעור כשלים נמוך ב‑deployment, וזיהוי מוקדם של model degradation.

השוואה מהירה: ML Dev לעומת MLOps

היבט | ML Developer | MLOps Engineer |

פוקוס עיקרי | מדע נתונים ואלגוריתמיקה | תשתיות, אוטומציה ואמינות |

מיומנויות | Python, PyTorch/TensorFlow, Stats | Docker, K8s, Airflow, Terraform |

שאלות יומיות | "איך לשפר את ה‑AUC?" | "למה ה‑latency עלה פתאום?" |

SLA מרכזי | Model performance | System availability & scalability |

ההבחנה הזו מאפשרת חלוקת עבודה יעילה: ML Dev בונה את "המוח", MLOps דואג שהוא פועל 24/7 בלי תקלות.

מחזור החיים של מודל ML: מי עושה מה

מודל למידת מכונה עובר מספר שלבים מובנים, מרגע זיהוי הבעיה העסקית ועד לתפעול מתמשך בפרודקשן. כל שלב כולל חלוקת אחריות ברורה בין ML Developer ל‑MLOps, עם נקודות ממשק מוגדרות מראש.

איסוף והכנת נתונים

- תפקיד ML Developer: מגדיר את סכמת הנתונים (features), בודק איכות נתונים ראשונית, מבצע feature engineering מתקדם ומתקן בעיות כמו missing values או imbalance.

- תפקיד MLOps: מקים Feature Store (כמו Feast או Tecton) לאחסון גרסאות נתונים, מגדיר pipelines אוטומטיים לרענון נתונים (ETL), ומוודא זמינות נתונים עבור אימונים עתידיים.

ניסויים ופיתוח מודל

- תפקיד ML Developer: בונה ובודק ארכיטקטורות מודל, מנהל ניסויים (hyperparameter tuning, A/B testing), בוחר את המודל הטוב ביותר ומתעד metadata (למשל, ב‑MLflow).

- תפקיד MLOps: מספק סביבת אימון סקיילבילית (GPU clusters), מגדיר versioning למודלים וניסויים, ומכין pipeline בסיסי לאימון אוטומטי.

אריזה ו‑API / שירות מודל

- תפקיד ML Developer: אריזת המודל (model packaging) בפורמט סטנדרטי כמו ONNX או SavedModel, כתיבת contract API (input/output schema), ובניית unit tests ללוגיקה של המודל.

- תפקיד MLOps: בונה container (Docker image) הכולל את המודל + dependencies, מגדיר health checks ו‑readiness probes, ומכין את המודל לפריסה כ‑microservice.

פריסה לפרודקשן (Deployment)

- תפקיד ML Developer: מספק ארטיפקטים מוכנים (מודל, metadata, tests) ומאשר גרסת המודל הסופית לאחר בדיקות מקומיות.

- תפקיד MLOps: פורס את המערכת כ שירות (Kubernetes, KServe, Seldon), מנהל blue-green deployment או canary releases, ומבצע smoke tests בפרודקשן.

ניטור, רה‑אימון ושיפור מתמשך

- תפקיד ML Developer: מנתח דוחות drift ו‑performance שמגיעים מ‑MLOps, מציע שיפורים במודל או features חדשים, ומפעיל re-training עם נתונים עדכניים.

- תפקיד MLOps: מריץ monitoring מקיף (data drift, concept drift, latency, error rates), מפעיל alerts אוטומטיים, ומתזמן re-training pipelines כאשר מגיעים לספים מוגדרים מראש.

נקודות הממשק העיקריות לאורך ה‑Pipeline

המפתח לשיתוף פעולה מוצלח הוא הסכמים מראש על ארטיפקטים שעוברים בין הצוותים:

- מודל + Metadata: קובץ מודל, hyperparameters, evaluation metrics, feature importance.

- נתונים: סכמה מדויקת, דוגמאות validation, ספים מינימליים לביצועים.

- תיעוד: API contract, deployment requirements (CPU/GPU/memory), SLA targets.

- פידבק loop: לוח מחוונים משותף לניטור, ticketing system לתקלות משותפות.

חלוקה זו מבטיחה שכל תפקיד מתמקד בחוזקות שלו, תוך שמירה על זרימה חלקה של המידע בין השלבים.

גבולות הגזרה והסינרגיה בין ML Dev ו‑MLOps

הבנת הגבולות בין התפקידים חיונית למניעת חיכוכים ולמקסום היעילות. בעוד ML Developer מתמקד באיכות המודל עצמו, MLOps דואג לאמינות המערכת כולה – אך יש אזורי חפיפה שבהם שיתוף פעולה הוא קריטי.

אחריות "קלאסית" של כל תפקיד

- אחריות שבדרך כלל נשארת אצל ML Dev: בחירת אלגוריתם ומודל, ניהול ניסויים והיפר-פרמטרים, ניתוח שגיאות מודל (כמו bias/variance), feature engineering מתקדם, ותקשורת עם בעלי עניין עסקיים.

- אחריות שבדרך כלל נשארת אצל MLOps: ניהול תשתיות (Kubernetes, cloud resources), בניית CI/CD pipelines, אבטחת מודלים (model security), ניטור תפעולי (latency, throughput), ותהליכי rollback ו-disaster recovery.

אזורי חפיפה טבעיים

אזורים אלו דורשים תכנון משותף מראש:

- Feature Store: ML Dev מגדיר features וסכמות, MLOps בונה ומתחזק את התשתית לאחסון וגישה מהירה.

- מדדי ביצוע למודל: הגדרת SLA משותפת (למשל, accuracy >85% ו-latency <200ms), כולל ספים ל-data drift ו-concept drift.

- דרישות Logging ו-Monitoring: ML Dev מציין אילו metrics חיוניים (predictions, probabilities), MLOps מיישם את המערכת (Prometheus, Grafana).

איך נראה שיתוף פעולה בריא

שיתוף פעולה מוצלח מבוסס על הסכמות ברורות וטקסים קבועים:

- הסכמות (Contracts) בין הצוותים: מסמך משותף שמפרט את הפורמט המדויק של model artifacts (מודל, schema, tests), דרישות חומרה מינימליות, ותהליך approval לפריסה.

- טקסים ותהליכי עבודה: Model design reviews משותפים לפני פיתוח, post-mortems על תקלות בפרודקשן, וישיבות שבועיות לניטור ותכנון re-training.

- אנטי-פטרנים שכדאי להימנע מהם: ML Dev שנכנס לתשתיות מורכבות (Kubernetes), MLOps שמתערב באלגוריתמיקה ללא רקע סטטיסטי, או חוסר תיעוד שגורם ל"מי אחראי על זה?".

הסינרגיה הזו יוצרת לולאת משוב מהירה: ML Dev משפר מודלים על בסיס נתוני פרודקשן, ו-MLOps מקבל מודלים איכותיים יותר שקל לפרוס ולהפעיל.

גבולות הגזרה והסינרגיה בין ML Dev ו‑MLOps

הבנת הגבולות בין התפקידים חיונית למניעת חיכוכים ומקסום היעילות. בעוד ML Developer מתמקד באיכות המודל עצמו, MLOps דואג לאמינות המערכת כולה – אך יש אזורי חפיפה שבהם שיתוף פעולה הוא קריטי.

אחריות "קלאסית" של כל תפקיד

- אחריות שבדרך כלל נשארת אצל ML Dev: בחירת אלגוריתם ומודל, ניהול ניסויים והיפר-פרמטרים, ניתוח שגיאות מודל (כמו bias/variance), feature engineering מתקדם, ותקשורת עם בעלי עניין עסקיים.

- אחריות שבדרך כלל נשארת אצל MLOps: ניהול תשתיות (Kubernetes, cloud resources), בניית CI/CD pipelines, אבטחת מודלים (model security), ניטור תפעולי (latency, throughput), ותהליכי rollback ו-disaster recovery.

אזורי חפיפה טבעיים

אזורים אלו דורשים תכנון משותף מראש:

- Feature Store: ML Dev מגדיר features וסכמות, MLOps בונה ומתחזק את התשתית לאחסון וגישה מהירה.

- מדדי ביצוע למודל: הגדרת SLA משותפת (למשל, accuracy >85% ו-latency <200ms), כולל ספים ל-data drift ו-concept drift.

- דרישות Logging ו-Monitoring: ML Dev מציין אילו metrics חיוניים (predictions, probabilities), MLOps מיישם את המערכת (Prometheus, Grafana).

איך נראה שיתוף פעולה בריא

שיתוף פעולה מוצלח מבוסס על הסכמות ברורות וטקסים קבועים:

- הסכמות (Contracts) בין הצוותים: מסמך משותף שמפרט את הפורמט המדויק של model artifacts (מודל, schema, tests), דרישות חומרה מינימליות, ותהליך approval לפריסה.

- טקסים ותהליכי עבודה: Model design reviews משותפים לפני פיתוח, post-mortems על תקלות בפרודקשן, וישיבות שבועיות לניטור ותכנון re-training.

- אנטי-פטרנים שכדאי להימנע מהם: ML Dev שנכנס לתשתיות מורכבות (Kubernetes), MLOps שמתערב באלגוריתמיקה ללא רקע סטטיסטי, או חוסר תיעוד שגורם ל"מי אחראי על זה?".

הסינרגיה הזו יוצרת לולאת משוב מהירה: ML Dev משפר מודלים על בסיס נתוני פרודקשן, ו-MLOps מקבל מודלים איכותיים יותר שקל לפרוס ולהפעיל.

כלים וטכנולוגיות: מה בארגז הכלים של כל אחד

כלים הם עמוד השדרה של שני התפקידים, אך יש חלוקה ברורה לפי שלב בעבודה. ML Developer משתמש בכלים מדעיים-ניסוייים, בעוד MLOps מתמקד בכלים תשתיתיים ואוטומציה. להלן המפה המרכזית.

כלים אופייניים ל‑ML Developer

כלים אלה תומכים בפיתוח מהיר וניסויים:

- סביבות פיתוח וניסוי: Jupyter Notebook/Lab, Google Colab, VS Code עם Python extensions.

- ספריות ML ו‑DL: scikit-learn (מודלים קלאסיים), PyTorch/TensorFlow (Deep Learning), Hugging Face Transformers (NLP).

- כלים לניהול ניסויים וגרסאות מודל: MLflow (experiment tracking), Weights & Biases (W&B), Neptune.ai.

כלים אופייניים ל‑MLOps

כלים אלה מבטיחים פריסה ואמינות בקנה מידה:

- CI/CD וצינורות אוטומציה: GitHub Actions, GitLab CI, Jenkins, Argo Workflows.

- תזמור ופריסה: Kubeflow Pipelines, Apache Airflow, Docker/Kubernetes, KServe/Seldon Core.

- ניטור מודלים ו‑Data/Concept Drift: Prometheus + Grafana, Evidently AI, WhyLabs.

טבלת כלים: מי משתמש במה ולמה

קטגוריה | כלי דוגמה | ML Developer | MLOps | שלב עיקרי בפייפליין |

פיתוח וניסויים | Jupyter, PyTorch, MLflow | ✓ ראשי | ✓ תמיכה (setup) | ניסויים + אימון |

Feature Engineering | Pandas, Feast | ✓ ראשי (features) | ✓ ראשי (store/infra) | הכנת נתונים |

CI/CD Pipelines | GitHub Actions, Airflow | ✓ ראשי | אימון + פריסה | |

פריסה | Docker, Kubernetes, KServe | ✓ אריזה בסיסית | ✓ ראשי (scaling/orchestration) | Deployment |

ניטור | Grafana, Evidently | ✓ ניתוח דוחות | ✓ ראשי (alerts/dashboards) | Production monitoring |

Model Registry | MLflow Registry, Harbor | ✓ העלאה | ✓ ראשי (versioning/security) | כל השלבים |

השימוש המשותף בכלים כמו MLflow או Feast יוצר גשר טבעי בין התפקידים, ומאפשר מעבר חלק של ארטיפקטים לאורך הפייפליין.

דוגמה מעשית: מסיפור משתמש למודל בפועל

כדי להמחיש את החלוקה והשיתוף בפועל, ניקח תרחיש מציאותי: פיתוח מודל חיזוי נטישה (Churn Prediction) עבור חברת תקשורת שרוצה להפחית נטישה ב-15% על ידי זיהוי לקוחות בסיכון מראש.

תיאור התרחיש

חברת תקשורת מקבלת נתוני לקוחות (שימוש, תלונות, תשלומים) ורוצה מודל שיציין ציון סיכון (0-1) לכל לקוח מדי שבוע. המודל יתממשק למערכת שיווק לשליחת הצעות מותאמות.

מה עושה ML Developer בכל שלב בתהליך

- נתונים: מנתח 6 חודשי היסטוריה, בונה features כמו "מספר ימי שימוש בחודש", "יחס תלונות/שימוש", ומטפל בחוסר איזון (לקוחות נוטשים הם 5% בלבד).

- ניסויים: בונה 3 מודלים (XGBoost, Random Forest, Neural Net), משתמש ב‑MLflow לעקוב אחר 50 וריאציות, ובוחר XGBoost עם F1-score של 0.82.

- אריזה: יוצר קובץ .pkl עם המודל, כותב predict_churn.py עם schema ברור (input: DataFrame, output: probability + risk_label).

- בדיקות סופיות: מאשר שהמודל עובר unit tests על דאטה חדש ומתעד feature importance.

מה עושה MLOps בכל שלב בתהליך

- נתונים: מקים Feature Store ב‑Feast שמריץ ETL יומי מדאטה lake, ומספק endpoint ל‑ML Dev לאימון מקומי.

- אימון: בונה Kubeflow pipeline שמריץ את קוד ה‑ML Dev על GPU cluster, שומר artifacts ב‑MLflow Registry.

- פריסה: יוצר Docker image עם המודל, מפרס כ‑Kubernetes service עם autoscaling, ומגדיר canary deployment (10% תנועה לגרסה חדשה).

- ניטור: מריץ Grafana dashboard עם metrics (latency <300ms, error rate <0.1%) + Evidently לזיהוי drift.

איך המידע זורם ביניהם בפועל

- Handover 1: ML Dev מעלה מודל ל‑MLflow Registry עם tag "ready_for_deploy".

- Handover 2: MLOps מפעיל smoke test בפרודקשן, שולח Slack notification עם תוצאות ל‑ML Dev.

- פידבק יומי: Dashboard משותף מציג accuracy בפרודקשן (ירד מ‑82% ל‑78%?), MLOps שולח ticket ל‑ML Dev לבדיקת drift.

מה קורה כשרואים Drift או ירידה בביצועים

שבועיים אחרי הפריסה, ה‑concept drift גורם לירידת F1 ל‑0.72:

- יום 1: Evidently מזהה drift ב‑feature "גלישה בחודש" (שונה מקורונה), MLOps שולח alert.

- יום 2: ML Dev מנתח logs, מגלה שינוי התנהגות עונתי, מציע features חדשים.

- יום 3: MLOps מפעיל re-training pipeline עם נתונים עדכניים, מפרס v1.1.

- יום 4: שניהם בודקים post-mortem ומעדכנים ספים ל‑drift detection.

תוצאה: זמן תיקון 3 ימים במקום שבועות, חיסכון של 200K ש"ח בנטישה מונעת. זהו בדיוק הכוח של חלוקה נכונה + לולאת משוב מהירה.

כיווני התפתחות קריירה ומודלים היברידיים

סיכום על התפקידים המרכזיים בעולם Machine Learning

שאלות נפוצות על MLops & ML dev

- מה ההבדלים בין שני התפקידים

- הגדרות תפקיד: ML Developer ו‑MLOps

- מחזור החיים של מודל ML: מי עושה מה

- גבולות הגזרה והסינרגיה בין ML Dev ו‑MLOps

- כלים וטכנולוגיות: מה בארגז הכלים של כל אחד

- דוגמה מעשית: מסיפור משתמש למודל בפועל

- כיווני התפתחות קריירה ומודלים היברידיים

- סיכום על התפקידים המרכזיים בעולם Machine Learning

- שאלות נפוצות על MLops & ML dev